隨著互聯網技術的飛速發展,網絡爬蟲作為一種自動化獲取網頁數據的重要工具,在信息收集、數據分析等領域發揮著日益重要的作用。許多網站為保護自身資源和用戶隱私,采取了反爬蟲機制,如基于User-Agent、IP頻率限制、JavaScript動態加載等技術手段。在此背景下,瀏覽器偽裝技術成為提升爬蟲效率與規避檢測的關鍵策略之一。本文旨在探討基于Python網絡爬蟲的瀏覽器偽裝技術,分析其原理、實現方法及其在網絡技術研究中的應用前景。

瀏覽器偽裝技術核心在于模擬真實瀏覽器的行為特征,以避免被服務器識別為爬蟲程序。常見的偽裝手段包括設置合適的請求頭(Headers),其中User-Agent字段尤為重要,通過復制主流瀏覽器(如Chrome、Firefox)的User-Agent字符串,可使爬蟲請求在表面上與普通用戶訪問無異。還需注意其他頭信息,如Referer、Accept-Language和Cookie等,這些細節的完善能顯著降低被封鎖的風險。

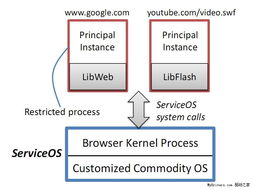

Python作為網絡爬蟲開發的流行語言,提供了豐富的庫支持瀏覽器偽裝。例如,使用Requests庫時,可以通過headers參數自定義請求頭;對于更復雜的場景,Selenium庫可模擬真實瀏覽器的完整行為,包括處理JavaScript渲染和會話管理。同時,結合代理IP輪換和請求延遲策略,可進一步分散訪問頻率,增強偽裝的可靠性。

在實現方法上,開發者需根據目標網站的反爬蟲強度靈活選擇技術組合。對于簡單的靜態網站,僅需修改User-Agent即可;而對于動態內容或高級反爬機制,則可能需要結合Selenium、Pyppeteer等工具,甚至分析網絡請求邏輯以模擬Ajax調用。代碼示例中,可通過Python腳本動態生成隨機User-Agent,或使用fake-useragent庫自動化處理,以提高偽裝效果。

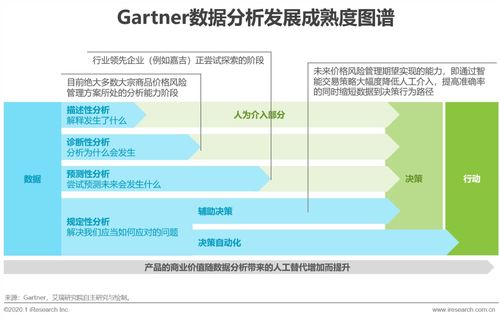

瀏覽器偽裝技術不僅提升了爬蟲的數據獲取能力,還推動了網絡技術研究的深入。例如,在網絡安全領域,該技術可用于漏洞掃描和滲透測試;在大數據分析中,它助力于實時監控和競爭情報收集。也需注意倫理與法律邊界,避免侵犯隱私或違反網站服務條款。未來,隨著人工智能和機器學習的發展,瀏覽器偽裝技術或將與自適應算法結合,實現更智能的反反爬蟲策略,為網絡技術研究開辟新方向。

基于Python的瀏覽器偽裝技術是網絡爬蟲開發中的重要環節,通過合理應用,可有效提升數據采集效率與成功率。本文探討了其原理與實現,并展望了其在網絡技術研究中的潛在價值,為相關從業者提供參考與啟示。